File - setarea corectă pentru a indexa un site în Yandex și Google

Primul lucru pe care un bot de căutare care vine la site-ul dvs., caută și citește fișierul robots.txt. Ce este un fișier robots.txt - un set de instrucțiuni pentru motorul de căutare. Acesta este un fișier text care este localizat în directorul rădăcină al unui site. Acest fișier indică crawler că indicele de site-ul și ceea ce nu este. Doar indică oglinda principală a site-ului și unde să caute o hartă a site.

De ce este nevoie pentru fișierele robots.txt? Pentru indexarea corectă a site-ului. Oricare ar fi constatarea nu a fost duplicat pagini, diferitele pagini și documente office. După ce configurați corect directivele din robots.txt vă va salva site-ul dvs. de la mai multe probleme cu indexare și site-ul zazerkalivaniem.

Cum sa faci o robots.txt corectă

Crearea robots.txt destul de ușor, creați un document text în Notepad pentru Windows. Scrierea în acest fișier directive pentru motoarele de căutare. Apoi, salvați acest fișier sub numele de «roboți» sau extinderea textului. Tot acum se poate completa pentru găzduirea directorul rădăcină al site-ului. Vă rugăm să rețineți, doar un singur robots.txt pot fi create pentru un singur site. Daca acest fisier nu este disponibil pe site-ul, bot automat „decide“, care poate indexa toate.

Din moment ce el este una, atunci există instrucțiuni scrise pentru toate motoarele de căutare. Și poate fi scris ca instrucțiune separată pentru fiecare substație și dreptul general sub ea. Separarea instrucțiunilor pentru o varietate de roboții motoarelor de căutare se face prin directiva User-agent. Vorbim mai multe despre asta mai târziu.

Directivele robots.txt

Fișierul robots.txt poate conține următoarele directive pentru a controla indexarea: User-agent, Disallow, permite, Harta site-ului, Host, crawl de întârziere, Clean-param. Să ne uităm la fiecare instrucțiune în detaliu.

Directiva User-agent

User-agent de directivă - puncte sunt instrucțiuni (sau mai degrabă unui robot specific) la un motor de căutare. Dacă există o „*“, atunci instrucțiunile sunt destinate pentru toți roboții. Dacă specificați un robot specific, de exemplu, prin Googlebot, atunci instrucțiunile sunt doar pentru robotul principal de indexare Google. Și dacă există instrucțiuni și separat pentru Googlebot și pentru toate celelalte state membre, Google citește numai manuale, și nu ia în considerare generală. Yandex bot va face același lucru. Vedem exemple de înregistrare directiva.

Utilizator-agent: YandexBot - instrucțiuni sunt valabile pentru bază Yandex indexare bot

User-agent: Yandex - instrucțiuni pentru toate Yandex Bot

User-agent: * - instrucțiuni pentru toți roboții

Disallow și Allow directivelor

Directiva Disallow andAllow - permite echipei acel index, și ceea ce nu este. Disallow nu instruiește să indexeze o pagină sau o secțiune a site-ului. O Lăsați contrariul indică faptul că doriți să indice.

Disallow: / - interzice indicele întregul site

Disallow: / papka / - interzice indicele de toate conținutul unui dosar

Disallow: /files.php - interzice fișierul index files.php

Allow: / cgi-bin - permite pagini de index cgi-bin

Disallow și Allow directive pot fi, și adesea au nevoie doar de a utiliza caractere speciale. Ei au nevoie pentru a defini expresii regulate.

Caractere speciale * - înlocuiește orice secvență de caractere. El a atribuit implicit la sfârșitul fiecărei reguli. Chiar dacă nu sunt înregistrate, ai SS ei înșiși executorii judecătorești. Exemplu de utilizare:

Disallow: /cgi-bin/*.aspx - interzice toate fișierele index cu aspx

Disallow: / * foto - să interzică indexarea fișierelor și foldere care conțin cuvântul foto

Caractere speciale $ - anulează wildcard „*“ la sfârșitul regulilor. De exemplu:

Disallow: / exemplu $ - interzice indicele „/ exemplu“, dar nu interzice „/example.html“

Și dacă $ prescrie lucrarea de instrucțiuni fără wildcard deja diferite:

Disallow: / exemplu - și interzice '/ de exemplu' și '/example.html'

Directiva Harta site-ului

Directiva Sitemap - concepute pentru a specifica motorul de căutare robot, în ce loc este pe o hartă a site hosting. site-ul format de hartă ar trebui să fie sitemaps.xml. Harta site-ului este nevoie de o indexare mai rapidă și completă a site-ului. Și harta site-ului nu este în mod necesar un singur fișier, pot exista mai multe. Directivele formatul de înregistrare:

Harta site-ului: /sitemaps1.xml

Harta site-ului: /sitemaps2.xml

Directiva gazdă

Directiva-gazdă - indică robotul site-ul principal de oglindă. Că nu au existat oglinzi în site-ul de index, ar trebui să specificați întotdeauna această directivă. În cazul în care nu indică Yandex robotul va indicele cel puțin două versiuni ale unui site cu și fără www. In timp ce robotul zerkalschik nu sunt lipite. Exemplu: intrări

Realizator: www.seob.info

Realizator: seob.info

În primul caz, indicele robotul va versiunea cu www, în al doilea caz nr. Permis să prevadă o singură directivă gazdă în robots.txt. Dacă indicați numărul lor, botul va prelucra și va lua notă de doar primul.

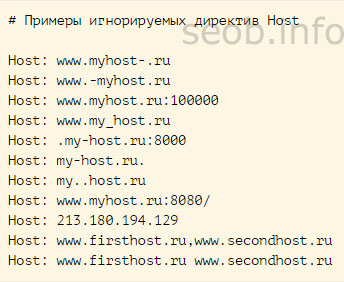

Nu a fost făcută în mod corespunzător de directivă va fi pur și simplu ignorate.

Directiva crawl de întârziere

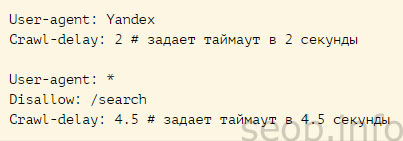

Directiva crawl de întârziere reduce sarcina pe server. Este necesar, în cazul în care site-ul dvs. începe să meargă sub atacul diferitelor roboți. Crawl de întârziere directivă specifică un bot de căutare timp de așteptare între sfârșitul injecției de o pagină și începutul injectării celorlalte pagini de pe site. Directiva ar trebui să vină imediat după directivele înregistrările «Interdicție» și «/ sau Permiteþi». Yandex căutare robot poate folosi pentru a citi valori fracționare. De exemplu: 1.5 (o jumătate de secundă).

Directiva Clean-param

Directiva Clean-param nevoie de site-uri, pagini care conțin parametri dinamici. Este vorba despre cei care nu afectează conținutul paginilor. Acesta este un alt serviciu de informații: Sesiunea Identificatorii, utilizator, referrer etc. Deci, care nu ar fi dublați aceste pagini și de a folosi această directivă. Ea spune că MS nu este re-încărca informații devine. Și reduce sarcina pe server, și în timp ce site-ul robotului crawling.

Clean-param: s /forum/showthread.php

Această intrare spune PS că parametrul s este considerat nesemnificativ pentru toate URL-Nu, care încep cu /forum/showthread.php. Lungimea maximă a record de 500 de caractere.

Pe directivele înțeles, se procedează pentru a personaliza fișierul Roboți noastre.

Setarea robots.txt

Mai departe direct la configurarea fișierului robots.txt. Acesta trebuie să conțină cel puțin două intrări:

User-agent: - puncte de la un motor de căutare va fi difuzate instrucțiunile de mai jos.

Disallow: - Specifică o parte a site-ului nu este indexat. Poate acoperi de a fi indexate ca un singur site pagini sau secțiuni întregi.

Și este posibil să se sublinieze că aceste orientări sunt destinate pentru toate motoarele de căutare, sau la unul anume. Se indică acest lucru în directiva User-agent. Dacă doriți să citiți instrucțiunile tuturor roboților - a pus „steaua“

Dacă doriți să vă înregistrați instrucțiuni pentru un anumit robot, dar este necesar să se precizeze numele acestuia.

Un exemplu simplificat al unui fișier robots.txt corect arată astfel:

User-agent: *

Disallow: /files.php

Disallow: / razdel /

Realizator: seob.info

În cazul în care, * se spune că instrucțiunile sunt pentru toate stațiile;

Disallow: /files.php - oferă o interdicție privind indexare fișier file.php;

Disallow: / foto / - interzice indexarea întreaga întreaga secțiune «foto» cu toate anexele;

Realizator: seob.info - indică roboți care indicele de oglinda.

Dacă nu există pagini de pe site-ul dvs., care trebuie să fie închise fie indexate, atunci fișierul robots.txt ar trebui să fie:

User-agent: *

Disallow:

Realizator: seob.info

Robots.txt pentru Yandex (Yandex)

Aceasta ar indica faptul că aceste instrucțiuni sunt pentru motorul de căutare Yandex, este necesar să se prevadă în directivă User-agent: Yandex. Și dacă vom prescrie «Yandex» site-ul va indexa toate roboți Yandex, și dacă indicăm «YandexBot» - aceasta va fi o echipa doar pentru robotul de indexare primară.

Precum și este necesar să se prevadă directiva «gazdă», care specifică site-ul oglinzii principale. Așa cum am scris mai sus, acest lucru se face în scopul de a evita pagini duplicat. Dreptul dvs. de robots.txt Yandex este:

User-agent: Yandex

Disallow: / cgi-bin

Disallow: / adminka

Realizator: seob.info

Harta site-ului: /sitemaps.xml

Pana acum am auzit de multe ori întrebări, este mai bine să se specifice gazdă în directivă, site-ul cu sau fara www. Dar nu există nici o diferenta. Aici pur și simplu doriți, că site-ul ar arăta să emită un PS. Este important să nu uitați să-l specificați deloc, ceea ce nu ar crea duplicate.

Robots.txt la Google

Motorul de căutare Google acceptă toate formatele comune robots.txt înregistrare a unui fișier. Adevărat, el nu ia în considerare directiva gazdă. Prin urmare, diferențe de la Yandex nu vor de fapt. Robots.txt la Google va fi după cum urmează:

User-agent: Googlebot

Disallow: / cgi-bin

Disallow: / adminka

Harta site-ului: /sitemaps.xml

Sper că informațiile le-am stabilit va fi suficient pentru a crea imagini de înaltă calitate, și cel mai important fișierul corect. robots.txt. Dacă utilizați una dintre cele mai populare CMS în următorul articol, am pregătit o selecție de roboți - robots.txt pentru populare CMS