File - setare și regulamentele interzic indexarea paginilor

Robots.txt - Acest fișier de serviciu, care servește ca o recomandare de a limita accesul la conținutul documentelor web pentru motoarele de căutare. În acest articol, vom discuta setarea robots.txt, descrierea și elaborarea unor linii directoare pentru CMS sale populare.

De ce am nevoie de robots.txt

Așa cum am menționat mai sus - folosind un fișier robots.txt, putem limita accesul roboților de căutare la documentele, adică ne afectează în mod direct indexarea site-ului. Cel mai adesea închisă de la indexare:

- fișiere și foldere oficiale CMS

- duplicate

- Documentele care nu transporta beneficii pentru utilizator

- Nu pagini unice

Să considerăm un exemplu specific:

Magazin online de vânzare pantofi și a realizat una dintre cele mai populare CMS, care nu este cel mai bun mod. Pot spune imediat că va emite o pagină de căutare, paginare, coș de cumpărături, unele fișiere cursor etc. Toate acestea vor fi duble și fișiere de servicii care sunt inutile pentru utilizator. În consecință, acestea trebuie să fie acoperite de indexare, iar în cazul în care există încă secțiunea „News“, în copy-paste sunt diferite articole interesante pentru site-uri ale concurenților - și apoi cred că nu este necesar, doar aproape.

directivele și normele de configurare robots.txt

User-agent. Acest apel la un anumit robot al unui motor de căutare sau pentru toate roboți. Dacă prescris numele specific al robotului, de exemplu «YandexMedia», general directivele user-agent nu sunt folosite pentru aceasta. Exemplu de scriere:

Disallow / Permite. Dezactiva / activa indexarea unui anumit document sau secțiune. Ordinea de scriere nu contează, dar 2 din directivă și cu același prefix, se acordă prioritate «Permite». Citește pe șenile lungimea lor prefix, de la cel mai mic la cel mai mare. Dacă trebuie să dezactivați indexarea paginii - trebuie doar să introduceți calea în raport cu acesta (Disallow: / blog / post-1).

Expresiile regulate * și $. Asteriscul înseamnă orice secvență de caractere (inclusiv martor). Semnul dolar înseamnă o întrerupere. Exemple de utilizare:

Directiva Harta site-ului. Dacă utilizați cartela site-ului (sitemap.xml) - atunci robots.txt trebuie indicate după cum urmează:

Directiva gazdă. După cum știți site-ul are o oglindă (pentru a citi cum a lipi site-ul oglindă). Această regulă specifică bot de căutare pe oglinda principală a vieții tale. Aceasta se referă la Yandex. Dacă aveți o oglindă fără WWW, vom scrie:

Vizitate în întârziere. Specifică reține (în secunde) între salturi bot documentelor. Prescris după directiva Disallow / Allow.

Clean-param. Acesta specifică bot de căutare, care nu are nevoie pentru a descărca informații suplimentare duplicat (ID-uri de sesiune, referrer, utilizator). Prescrierea Clean-param ar trebui să fie pagini dinamice:

Regula principală: robots.txt trebuie să fie scrise în litere mici și se află la rădăcina site-ului. Structura fișier EXEMPLU:

Roboți meta tag-ul și modul în care este prescris

Această opțiune ia în considerare interzicerea pagini mai bune motor de căutare Google. Yandex la fel de bine să ia în considerare atât.

Pentru fiecare pagină, vă puteți înregistra în tag-ul

următor:fișierele robots.txt corecte pentru populare CMS

exemplu Robots.txt pentru WordPress

Mai jos puteti vedea versiunea mea a unui blog SEO.

Utilitare dosar și fișiere de orice CMS încerc închid, pentru că Nu vreau ca ei să cadă în index (deși motoarele de căutare deja, și așa nu iau, dar nu va fi mai rău).

Hrana (hrana pentru animale) este închis, deoarece Acest parțiale sau complete de pagini dubluri.

Tag-uri închide, dacă nu folosim, sau lene, le optimiza.

Exemple pentru alte CMS

Pentru a descărca roboți corecte pentru CMS dreapta, pur și simplu faceți clic pe link-ul corespunzător.

Cum de a verifica corectitudinea operațiunii fișierului

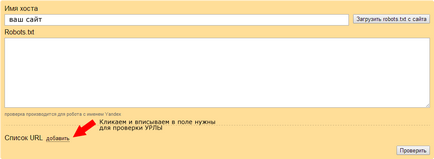

Analizați robots.txt în Yandex Webmaster - aici.

Privim și ajustați, dacă este necesar.

Întrebări populare despre robots.txt

Cum de a închide site-ul de la a fi indexat?

Cum de a preveni indexarea paginii?

Cum previn oglinda de indexare?

Pentru a stoca costurile de închidere coș (coș)?

Am un site web fara un CMS, dacă am nevoie de roboți?

- Da pentru a specifica gazdă și sitemap-ul. Dacă aveți dubluri - că, pe baza situației le închide.

O altă întrebare la care nu se poate găsi răspunsul. Aș fi recunoscător pentru opinia ta. Permiteți-mi să vă reamintesc că site-ul meu - nu este un blog, iar site-ul unei mici agentii imobiliare.

Site-ul pe WordPress, corectat roboții în conformitate cu recomandările și exemplele de pe diverse site-uri. Alături de alte directive și acestea sunt:

Disallow: / wp-include /

Disallow: / wp-content / plugins /

Disallow: / wp-content / teme /

Verificați paginile mele în Google pentru webmasteri, consultați „Vezi ca Googlebot». Cu aceste robors pagini sunt afișate numai text, care este, site-ul arata ca un semi-tesatura. O fotografie, design, elemente de design, tabele, etc. nu sunt vizibile. Aceasta indică faptul că blocarea acestor elemente se datorează următoarelor directive:

Disallow: / wp-include /

Disallow: / wp-content / plugins /

Disallow: / wp-content / teme /

În acest context, întrebarea. Trebuie să fie, astfel încât site-ul arata ca un trunchiat pentru motoarele de căutare? Sau este ca acesta să fie declasate în rezultatele motoarelor de căutare, datorită faptului că se pare în ochii lor greșită? În cazul în care acesta din urmă este adevărat, atunci ce ar trebui făcut pentru a rectifica situația?

Sergey K. adăuga roboți:

Permite: / wp-content / uploads / * / * /

Restul - SS nu sa uitat la site-ul ca utilizatorii normali.

Vă mulțumesc foarte mult, Roman, care au răspuns la cererea mea. Și voi face ca te sfătuiesc.

Vă mulțumim pentru articol informativ. Acum știu că site-ul meu a făcut fișier robots.txt greșit. Prin urmare, vă rugăm să clarifice următoarele:

Dacă este necesar, care dintre ele?

Multumesc anticipat.