Cum de a crea o corectă, seogio

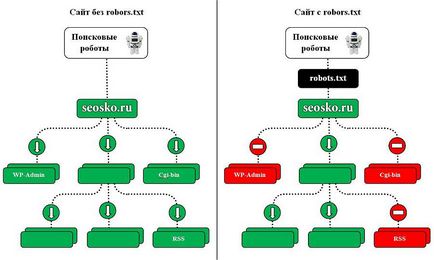

Fișierul robots.txt este una dintre cele mai importante în optimizarea orice site. Lipsa acestora poate duce la o încărcare mare la site-ul de la motoarele de căutare și indexare lentă și re-indexare, deoarece nu va fi indexat de ajustare necorespunzătoare a faptului că site-ul este dispărea complet de căutare sau pur și simplu. Prin urmare, nu va fi căutat în Yandex, Google și alte motoare de căutare. Să înțeleg toate nuanțele de configurare corespunzătoare a robots.txt.

Cum robots.txt pentru site-ul de indexare

păianjeni motorul de căutare va indexa site-ul dvs., indiferent de prezența unui fișier robots.txt. În cazul în care există un astfel de fișier, robotul poate fi ghidat de regulile care sunt scrise în acest fișier. Cu toate acestea, unii roboți pot ignora aceste sau alte reguli, sau unele dintre regulile pot fi specifice doar pentru unele roboții. În special, Googlebot nu folosește directiva-gazdă și de crawl-Delay, YandexNews a început recent să ignore directiva crawl de întârziere, și YandexDirect YandexVideoParser și să ignore orientările generale în mai Roboți (dar ghidat de către cei care sunt indicate în mod special pentru ele).

Sarcina maximă pe site-ul a crea roboți care descarcă conținut de pe site. Prin urmare, subliniind că este indexat, și ce să ignore, și cu ce intervale de timp pentru a face descărcarea, puteți, pe de o parte, reduce în mod semnificativ sarcina pe site-ul de robot, iar pe de altă parte, pentru a accelera procesul de descărcare, care interzice pagini inutile târască .

Aceste pagini sunt script-uri care nu sunt necesare, ajax JSON, responsabil pentru formele pop-up, bannere, etc. concluzie captcha formular de comandă și coș de cumpărături, cu toate etapele din, funcția de căutare, birou privat, panoul de administrare.

Pentru cei mai mulți roboți este de asemenea de dorit să dezactivați indexarea tuturor JS și CSS. Dar trebuie să plece index, deoarece acestea sunt utilizate de motoarele de căutare pentru a analiza comoditatea site-ului și clasarea acestuia (PRF Google. Dovada Yandex) astfel de fișiere pentru Googlebot și Yandex.

Directivele robots.txt

Să ne uităm la comanda.

User-agent

Aceasta este prima directivă, care determină pentru orice roboți urmat regulile.

Pentru toate roboți:

User-agent: *

Pentru un anumit bot:

User-agent: GoogleBot

Vă rugăm să rețineți că există în robots.txt sensibilă la caz. Ie agentul utilizator pentru Google poate fi la fel de bine scris Soledad mod:

user-agent: googlebot

Tabelul de mai jos prezintă principalele user-agent de diferite motoare de căutare.

Disallow și Allow

Dar acest lucru nu este atât de simplu.

În primul rând, trebuie să cunoască și să înțeleagă operatori suplimentari, modul în care acestea sunt utilizate - l *, și # $.

Disallow S = * :?

Disallow: / categorie / $

În al doilea rând, trebuie să înțelegeți modul de a rula reguli imbricate.

Amintiți-vă că ordinea scrierii directivelor nu este importantă. regulile de moștenire, care deschide sau a închide de indexare se determină în conformitate cu care directoarele sunt listate. Să considerăm următorul exemplu.

Permite: * .css

Disallow: / template /

Dacă doriți ca toate fișierele .css au fost deschise pentru a indexa va avea un registru suplimentar pentru fiecare dosar închis. În cazul nostru:

Permite: * .css

Permite: /template/*.css

Disallow: / template /

Din nou, ordinea directivelor nu este importantă.

Directiva Harta site-ului sunt specificate într-un fișier robots.txt oriunde, fără a fi legat de un anumit user-agent. Puteți specifica mai multe reguli de Sitemap.

Exemplul 1:

Realizator: site.ru

Crawl de întârziere

Directiva pentru a stabili intervalul de timp între paginile robotului descărcarea. Sprijinit de roboți Yandex, Mail.Ru, Bing, Yahoo. Valoarea poate fi setată în totalitate sau unități de fracționare (separator - puncte), timp în secunde.

Exemplul 1:

De crawl-întârziere: 3

EXEMPLUL 2:

Crawl-delay: 0,5

Daca un site are o sarcină mică, necesitatea de a stabili o astfel de regulă nu. Cu toate acestea, în cazul în care paginile de indexare roboți conduce la faptul că site-ul depășește limitele sau se confruntă cu sarcini grele de până la întreruperea serverului, această directivă va ajuta la reducerea sarcinii.

Cu cât valoarea, cu atât mai puțin pagini robotul de încărcare pe sesiune. Valoarea optimă este determinată în mod individual pentru fiecare site. Este mai bine să se înceapă cu valori nu foarte mari - 0,1, 0,2, 0,5 - și le crește treptat. Pentru roboții motoarelor de căutare cu o valoare mai mică pentru promovarea rezultatelor, cum ar fi Mail.Ru, Bing și Yahoo pot fi setate inițial valori mai mari decât cele pentru Yandex robot.

Clean-param

Yandex recomandă, de asemenea, utilizarea acestei directive pentru a nu lua în considerare UTM-etichetă și ID-urile de sesiune. exemplu:

alte opțiuni

În caietul de sarcini robots.txt extins puteți găsi mai multe opțiuni Cerere-rata și vizita-time. Cu toate acestea, ele nu sunt acceptate în prezent de cele mai importante motoare de căutare.

Sensul directivelor:

Cerere-rata: 1/5 - nu pentru a încărca mai mult de o pagină în cinci secunde

Vizitați-time: 0600-0845 - paginile se încarcă într-un interval de numai de la 6 am la 08:45 GMT.

robots.txt de închidere

Dacă aveți nevoie pentru a personaliza site-ul dvs. nu este indexat de motoarele de căutare, va trebui să se înregistreze următoarele directive:

Verificați dacă aceste directive au fost înregistrate pe zonele de testare a site-ului.

Configurarea corectă a robots.txt

Pentru a configura în mod corespunzător utilizarea robots.txt următorul algoritm:

exemplu robots.txt

Cum și unde să adăugați robots.txt

Cum se verifică robots.txt

- În Yandex.Webmaster - pe fila Instrumente> Analizați robots.txt

- Google Search Console - Fila Scan> robots.txt Tester instrument

greșeli comune în robots.txt

- lipsă robots.txt

- în site-ul dvs. robots.txt este închisă de la indexare (Disallow: /)

- în fișierul conține numai cele mai multe orientări de bază, nici un studiu detaliat al fișierului

- în fișierul nu este închis pe indexul paginii cu ID-ul UTM-etichetat și sesiune

- Numai în dosarul specificat de directivă

Permite: * .css

Allow: * .js

Permite: * .png

Permite: * .jpg

Permite: * .gif

în timp ce fișiere css, js, png, jpg, gif acoperite de alte directive într-un număr de directoare - Directiva gazdă este scris de mai multe ori

- în gazdă protocolul HTTPS Necunoscut

- calea către Sitemap nu este valid sau un protocol invalid sau un site oglindă

Yandex scrie:

„Directiva gazdă

Set de domeniu în cazul în care instrucțiuni similare într-un fișier robots.txt lipsesc.

orientări directivă la Host au fost luate în considerare, directivele identice ar trebui

să fie prezente în fișierele robots.txt ale tuturor site-uri oglindă.

Verificați fișierul robots.txt și de a elimina contradicții. "

Când am adăuga la webmaster, el a fost deja pe protocolul HTTPS, adică Am înțeles mutarea nu a fost. Robots.txt la gazdă specificat de domeniu fără protocol, cum ar fi asa - Realizator: site-ul, ru

Ajutor pentru a înțelege motivul. Acesta poate fi corectat gazdă, așa că a fost cu protocolul HTTPS?

Aici el robots.txt

User-agent: *

Disallow: / cgi-bin

Disallow: / wp-admin

Disallow: / wp-include

Disallow: plugins / wp-content /

Disallow: / wp-content / cache

Disallow: teme / wp-content /

Disallow: * / trackback

Disallow: * / hrana pentru animale

Disallow: / *?

Disallow: / autor /

Disallow: /transfers.js

Disallow: /go.php

Disallow: /xmlrpc.php

User-agent: Yandex

Disallow: / cgi-bin

Disallow: / wp-admin

Disallow: / wp-include

Disallow: plugins / wp-content /

Disallow: / wp-content / cache

Disallow: teme / wp-content /

Disallow: * / trackback

Disallow: * / hrana pentru animale

Disallow: / *?

Disallow: / autor /

Disallow: /transfers.js

Disallow: /go.php

Disallow: /xmlrpc.php

Realizator: site-ul, ru

User-agent: Googlebot

Permite: * .css

Allow: * .js

Permite: /wp-includes/*.js

Disallow: / cgi-bin /

Disallow: / wp-admin /

Disallow: / wp-include /

Disallow: / wp-content / cache

Disallow: * / trackback

Disallow: * / hrana pentru animale

Disallow: / autor /

Disallow: /transfers.js

Disallow: /go.php

Disallow: /xmlrpc.php

Disallow: / *?

Dacă Clean-Param, apoi ignora. Google nu știe acest parametru și îngrijorat, dintr-o dată sunteți o echipă importantă pentru el a vrut să scrie și să facă o greșeală.

Ok, mulțumesc. Cred că ar putea fi luate în considerare și regulile de concurentul său, sau este politica lor la astfel de competitori agresivi ...))